| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- 아이폰

- 마이크로소프트

- google i/o

- Apple

- iOS 8

- 윈도우 10

- OS X 요세미티

- 머티리얼 디자인

- 안드로이드

- 윈도우 7

- 맥

- 어도비

- L Developer Preview

- 야후

- OS X

- 유틸리티

- 크롬북

- 윈도우 8

- WWDC

- ios

- 안드로이드 웨어

- 삼성 기어 라이브

- 구글 I/O

- LG G Watch

- 웨어러블 기기

- Bash

- 애플

- 아이폰 6

- 구글

- 윈도우

All Things IT

Google I/O 2019 요약, 정리 - "AI for Everyone", Pixel 3a도 발표 본문

Google은 5월 7일(현지 시간) 본사 캠퍼스 근처의 야외 홀 Shoreline Amphitheatre에서 연례 개발자 회의 "Google I / O 2019"의 기조 강연을 개최했다. 이 자리에서 발표된 것을 시간순으로 정리한다.

올해의 오프닝 동영상은 흑백의 "스타 트렉" 영상(Mr. 스팍이 컴퓨터를 조작하는 장면)에서 현대까지 AI와 로봇의 진화를 나타내는 것이었다(Pixel 3a의 티저로 사용된 "어벤져스:엔드 게임"은 기조 강연의 끝까지 등장하지 않았다). 동영상의 마지막 메시지는 "Keep making magic. (마법을 계속해서 실현하자)".

행사를 시작하며 무대로 오른 순다 피차이 CEO는 Google의 미션인 "세계의 정보를 정리하여 전세계 사람들이 편리하게 이용할 수 있도록 하는 것"을 언급한 후 "우리는 사람들이 해답을 찾을 수 있도록 도움을 주는 기업에서 하고자 하는 일을 이루도록 돕는 기업으로 도약할 것"이라고 말했다. 올해 I/O의 주제는 "Building a more helpful Google for everyone(모든 사람에게 더욱 도움이 되는 Google을 만드는 것)"이다.

검색 3D AR기능

처음으로 소개한 것은 Google 검색에서 검색한 동물과 인체 등의 이미지를 3D화하거나 AR로 표시하는 새 기능이다. 예를 들면 "백상어"을 검색하고 이미지를 터치하면 3D로 표시되고, 한 번더 터치하면 실물 크기의 AR로 표시한다. AR 환경에서 봄으로써 실제 크기(백상어는 약 5.5미터)를 실감할 수 있게 된다.

Google은 이 기능을 위해 NASA, New Balance, Samsung, Target, Visible Body, Volvo, Wayfair등과 제휴했다. 이들 기업이 다루는 이미지 데이터를 통해 3D→AR이 가능하게 된다.

이 기능은 5월 중에 점진적 업데이트 방식으로 적용될 전망이다.

Google Lens의 새 기능(메뉴에서 인기 메뉴 추천 및 번역)

2017년 Google I/O로 등장한 이미지 정보 검색 AI "Google Lens"도 진화한다.

시연에서는 레스토랑의 메뉴를 스마트폰 카메라로 찍고 Google Lens를 실행하면 그 가게의 인기 메뉴가 강조 표시되는 모습을 선보였다. 강조 표시된 메뉴를 터치하면 그 메뉴에 대한 리뷰가 표시된다.

위치 정보에서 이 레스토랑을 파악하고 Google 지도에 있는 리뷰 정보를 가져옴으로써 기능을 구현했다는 설명도 덧붙였다.

시연에서는 레스토랑의 영수증을 카메라로 찍자 팁의 계산을 자동으로 하는 기능도 소개됐다.

그 밖에도 간소화된 검색 앱 "Google Go"에서도 Google Lens를 사용할 수 있게 된다. Google Go를 사용하는 저가형 기기에서도 Lens를 사용하여 텍스트의 음성 낭독이나 번역이 가능하게 된다. 이 기능을 사용하면 예를 들어 해외 여행지의 간판 등을 텍스트로 인식시킨 뒤 우선 자국어로 번역하고 그것을 음성 낭독하는 일이 가능하다.

Duplex가 Web브라우저에

지난해 Google I/O에서 많은 사람을 놀라게 한 "Duplex"가 Android 기기의 Chrome 브라우저, 캘린더, Gmail에서 사용할 수 있게 된다.

시연에서는 웹 에서 렌터카를 예약하는 방법이 소개됐다. 렌터카 웹사이트를 열고 여러 단계를 거쳐 예약하는 대신 "OK Google, 다음 여행을 위해 National Car Rental에서 렌터카를 준비해줘"라고 음성으로 명령하면 Duplex가 메일로부터 "다음 출장"의 정보를 모아 출장지의 렌터카 사무실을 파악하고 사용자의 과거 렌터카 이력에서 후보 차량까지 제시했다.

이 기능은 연내에 미 현지에서 영어로 이용 가능하게 될 전망이다.

차세대 Google 어시스턴트, 데이터 소비 절감으로 10배 빨라

현재 "Google 어시스턴트"가 사용자의 요청을 분석하려면 100GB 정도의 데이터를 필요로하지만 차세대 어시스턴트는 0.5GB의 데이터로 요청을 이해한다. 이 진화로 Google 어시스턴트는 단말기 내에서 데이터를 처리할 수 있게 되고, 오프라인에서도 이용 가능하게 되며, 10배 빨라진다.

시연에서는 다양한 명령을 잇달아 내리고 어시스턴트가 그에 대응하는 모습이 소개되었다. 시연에서는 각 명령 사이에 "OK Google"등의 호출 단어는 말하지 않았다.

차세대 Google 어시스턴트는 올 가을 출시 예정인 차기 Pixel 단말기(가칭 Pixel 4)에서 이용 가능하게 될 전망이다.

Google 지도에도 "시크릿 모드"

Chrome 브라우저와 "YouTube"에서 기록을 남기지 않고 웹을 사용할 수 있는 "시크릿 모드"가 "Google 지도"에서도 사용할 수 있게 된다. 목적지 검색 등이 기록으로 남지 않는다.

Google은 위치 정보를 해제하고도 추적을 계속하여 비판 받은 후 개인 정보 관련 기능을 개선하고 있다.

지난 주에는 "Google 계정" 설정에서 기록 보존 기간을 선택할 수 있도록 했다.

접근성 관련(라이브 자막이나 라이브 음성 낭독)

"for everyone"의 일환으로 접근성 관련 새 기능도 발표했다.

"Live Caption"은 말 그대로 실시간으로 음성 캡션 (자막)를 붙이는 기능이다. 2월에 발표한 "Live Transcribe" 와 같은 기술을 채용하고 있다.

스마트폰에서 YouTube 영상이나 Instagram의 동영상, Duo 대화 등의 음성 포함 동영상, 팟캐스트 및 음성 채팅 등의 오디오가 재생되면 Live Caption 기능에 의해 자동적으로 자막이 표시된다. 이 기능은 80MB의 작은 용량으로 오프라인에서도 이용 가능하다.

If it has audio, now it can have captions. Live Caption automatically captions media playing on your phone. Videos, podcasts and audio messages, across any app—even stuff you record yourself. #io19 pic.twitter.com/XAW3Ii4xxy

— Google (@Google) 2019년 5월 7일

마찬가지로 목소리를 내지 못하는 사람이 스마트폰에 텍스트를 입력하여 음성으로 변환하는 "Live Relay"도 소개했다.

또 ALS 환자 등 대화가 어려운 사람을 위한 노력의 일환인 "Project Euphonia"에서 개인의 특정 소리와 몸짓을 등록하고 언어로 "번역"하는 기술을 개발하고 있음도 소개했다.

Android Q는 공식적으로 "Android 10"

"Android Q"라고 소개된 차기 Android OS가 "Android 10"으로 명명됐다. 이와 함께 새 기능이 소개됐다.

5G에 대한 대응, 다크 테마, 보안 기능, 스마트 멘션 등의 기능을 시연했다.

새로운 Android Q의 베타 버전은 Pixel 뿐만 아니라, LG, 노키아의 단말에서도 시험할 수 있다.

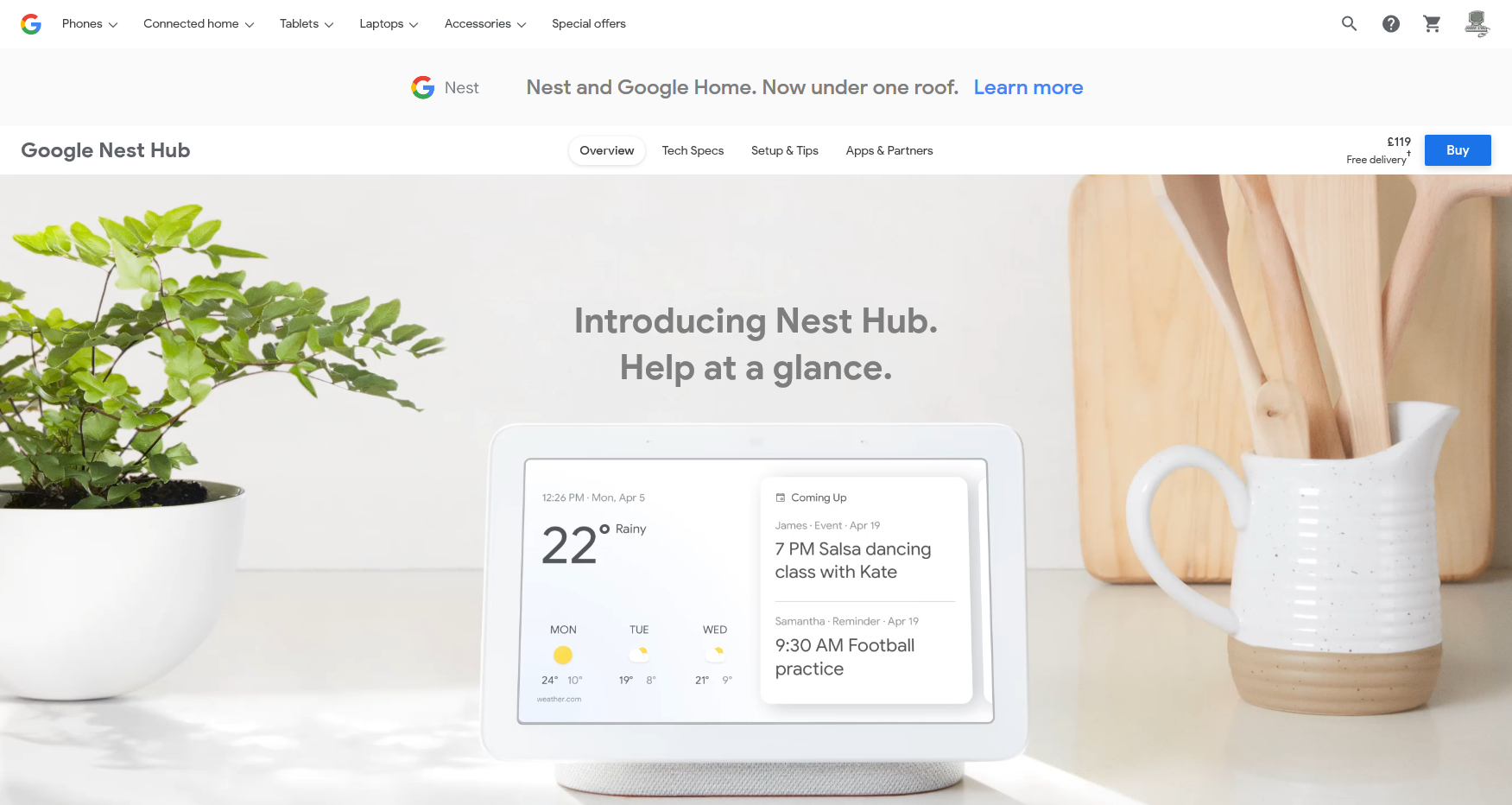

스마트 디스플레이 "Nest Hub"와 "Nest Hub Max"

Google은 지난해 2월 Nest를 Google의 하드웨어 팀에 통합했다. 릭 오스텔로 수석 부사장은 기조 연설에서 Made by Google의 하드웨어를 Nest 브랜드로 정리해 나갈 계획을 발표했다.

그 일환으로 지난해 10월에 발표했던 "Google Home Hub"을 "Nest Hub"로 개명했다.

또 Nest Hub의 상위 모델로서 새롭게 "Nest Hub Max"를 발표했다. 한국에는 아직 출시되지 않는다.

Pixel 3a와 3a XL 발표

소문으로 알려져 있던 중급 사양과 가격의 스마트폰 "Pixel 3a"와 "Pixel 3a XL"도 발표됐다.

이 제품도 "Google for everyone"의 일환이다. 고가의 Pixel 시리즈에 있던 뛰어난 기능을 모든 사람에게 전달하는 것이 목적이다. 현재 하이엔드 스마트 폰에서 사라졌던 3.5㎜ 오디오 잭을 부활시킨 것도 무선 이어폰을 구입할 수 없는 사용자층에 대한 배려인 것 같다.

호주, 캐나다, 프랑스, 독일, 인도, 아일랜드, 이탈리아, 일본, 싱가포르, 스페인, 대만, 영국, 미국의 13개국에서 이날부터 예약을 받아 17일에 발매한다. 가격은 Pixel 3a가 399달러(약 46만 원), Pixel 3a XL이 479달러(약 56만 원)이다.

AI 개발 현황

마지막 발표자는 회사 광고 기술에서 딥 러닝까지 폭넓은 제품 출시에 참여했던 Google Senior Fellow인 제프 딘이었다. 범용 언어 표현 모델인 "BERT(Bidirectional Encoder Representations from Transformers)"나 TensorFlow의 진척 상황, AI를 의료나 재해 대응을 위해 활용하여 더 많은 사람을 살리기 위한 노력 등에 대해 이야기했다.

덧붙여서 언급이 예상되던 게임 스트리밍 서비스 "Stadia", VR관련 자율 운전차 기업 Waymo에 대해서는 적어도 기조 연설에서는 접할 수 없었다.

기조 연설의 녹화는 이미 YouTube에 공개되어 있다.

'뉴스 + 소식' 카테고리의 다른 글

| [속보] iPod Touch 2019년 모델 발표, A10 Fusion 칩 탑재하고 약 23만 6,700원부터 시작 (0) | 2019.05.29 |

|---|---|

| iPhone SE2(가칭)가 2020년 초에 등장? 2020년의 iPhone은 전체 화면 Touch ID 채용할 것으로 애널리스트 예측 (0) | 2019.05.25 |

| 새 Mac Pro와 디스플레이는 6월 WWDC에서 발표? macOS 10.15에 iOS 앱 다수를 이식한다는 소문 (0) | 2019.05.07 |

| Microsoft, 웹 브라우저에서 작동하는 "Visual Studio Online"을 발표 (0) | 2019.05.07 |

| 페이스북, 정책위반 컨텐츠 검출 AI 강화로 '인터넷 괴롭힘' 검출율 85% 향상 (0) | 2019.05.05 |